- Регистрация

- 15 Февраль 2018

- Сообщения

- 10 278

- Лучшие ответы

- 0

- Баллы

- 1 295

Offline

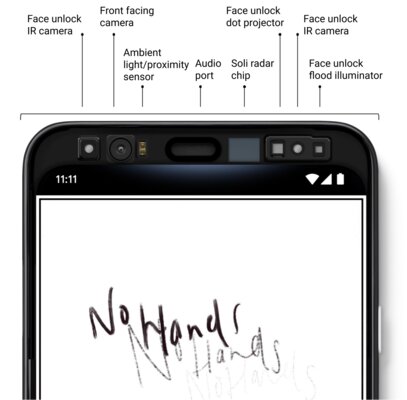

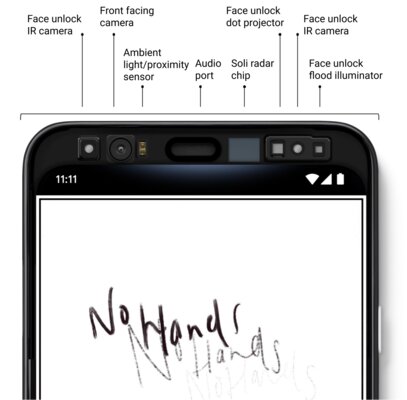

С выходом смартфонов серии Pixel 4, компания Google представила технологию Motion Sense для управления некоторыми действиями на устройстве с помощью воздушных жестов и встроенного радара Soli. Ранее поисковый гигант уже объяснял, как она работает, а теперь показал, что именно видит крошечный радар.

В сообщении Google говорится, что Soli работает не совсем так, как могли ожидать от него большинство пользователей. По словам компании, для работы радара потребовалось много новых технологий глубокого обучения. Soli — радар ближнего действия, который может делать две вещи: определять присутствие пользователя, чтобы подготовить экран к разблокировке по лицу, и реагировать на жесты в воздухе, которые выполняются строго над смартфоном.

Радар состоит из излучателей и приёмников радиосигнала, которые определяют движение объекта, но не форму. Это имеет дополнительное преимущество для конфиденциальности, поскольку Soli не может сформировать чёткое изображение человека, его лица или другой части тела. Задача Google состояла в том, чтобы быстро и точно интерпретировать движения, чтобы выяснить, что делает пользователь. В то же время радар должен был учитывать движение устройства, например, при ходьбе или вибрации, когда играет музыка.

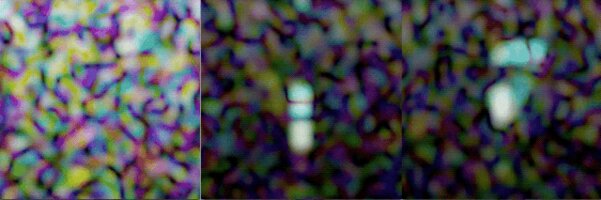

Именно поэтому Soli видит мир как своего рода трёхмерный график с расстоянием до объекта по вертикальной оси, скоростью, направлением и яркостью каждого пикселя, представляя относительный размер обнаруженного объекта. Полученные данные выглядят следующим образом:

Анимация доступна по нажатию.

Слева направо: человек, идущий к смартфону; человек, протягивающий руку к смартфону; человек, выполняющий жест (смахивание) над смартфоном.

Используя эти данные, исследователи создали ИИ-алгоритм и обучили систему на миллионах жестов, записанных тысячами добровольцев. Их сравнили с радиолокационными записями для создания моделей искусственного интеллекта с использованием платформы машинного обучения TensorFlow от Google. Всё это было оптимизировано для работы на кастомных сигнальных процессорах Pixel 4 со скоростью до 18 тыс. кадров в секунду.

Пока Soli может определять только относительно простые жесты, но у Google большие надежды на то, что в будущем он сможет делать намного больше. Компания верит, что однажды эту технологию можно будет использовать на небольших устройствах, например, в умных часах, где жесты окажутся более полезными. Кроме того, она может найти применение в сфере образования, а также там, где приоритете безопасность.

В сообщении Google говорится, что Soli работает не совсем так, как могли ожидать от него большинство пользователей. По словам компании, для работы радара потребовалось много новых технологий глубокого обучения. Soli — радар ближнего действия, который может делать две вещи: определять присутствие пользователя, чтобы подготовить экран к разблокировке по лицу, и реагировать на жесты в воздухе, которые выполняются строго над смартфоном.

Радар состоит из излучателей и приёмников радиосигнала, которые определяют движение объекта, но не форму. Это имеет дополнительное преимущество для конфиденциальности, поскольку Soli не может сформировать чёткое изображение человека, его лица или другой части тела. Задача Google состояла в том, чтобы быстро и точно интерпретировать движения, чтобы выяснить, что делает пользователь. В то же время радар должен был учитывать движение устройства, например, при ходьбе или вибрации, когда играет музыка.

Именно поэтому Soli видит мир как своего рода трёхмерный график с расстоянием до объекта по вертикальной оси, скоростью, направлением и яркостью каждого пикселя, представляя относительный размер обнаруженного объекта. Полученные данные выглядят следующим образом:

Анимация доступна по нажатию.

Слева направо: человек, идущий к смартфону; человек, протягивающий руку к смартфону; человек, выполняющий жест (смахивание) над смартфоном.

Используя эти данные, исследователи создали ИИ-алгоритм и обучили систему на миллионах жестов, записанных тысячами добровольцев. Их сравнили с радиолокационными записями для создания моделей искусственного интеллекта с использованием платформы машинного обучения TensorFlow от Google. Всё это было оптимизировано для работы на кастомных сигнальных процессорах Pixel 4 со скоростью до 18 тыс. кадров в секунду.

Пока Soli может определять только относительно простые жесты, но у Google большие надежды на то, что в будущем он сможет делать намного больше. Компания верит, что однажды эту технологию можно будет использовать на небольших устройствах, например, в умных часах, где жесты окажутся более полезными. Кроме того, она может найти применение в сфере образования, а также там, где приоритете безопасность.